(相关资料图)

(相关资料图)

本报讯(记者陈彬)近日,清华大学计算机系研究团队与深圳国际研究生院团队合作,在大规模语言预训练模型前沿领域取得新进展。相关研究成果“面向大规模预训练语言模型的参数高效微调”以封面文章形式发表于《自然-机器智能》。

2018年以来,预训练语言模型(PLM)及其“预训练-微调”方法已成为自然语言处理(NLP)任务的主流范式。规模越大的模型不仅在已知任务上有着更好的表现,同时展现出完成更复杂的未知任务的强大泛化能力,近年出现的GPT-3、ChatGPT等均为大规模预训练模型的代表。

然而,现有对大规模预训练模型的全部参数进行微调实现任务适配的做法,会消耗大量图形处理器(GPU)计算资源和存储资源,严重限制大模型的应用场景。为了应对该挑战,参数高效微调方法逐渐受到关注。

研究团队提出,参数高效微调方法的本质是对“增量参数”进行调整,因此将此类方法命名为“增量微调”,并基于统一的分析框架对增量微调现有方法进行梳理总结,将现有方法分为3类——添加式、指定式和重参数化方法。为了指导后续的模型架构和算法设计,团队进一步从参数优化和最优控制两个角度,提出了增量微调的理论框架,为探索和解释增量微调的内在机理提供了可行方案。

该研究工作选择了超过100个NLP任务,对主流增量微调方法进行了全面细致的性能比较和分析,得出多项重要结论。比如,基础模型随着参数规模的不断增大,在性能显著提高的同时,不同增量微调方法的差异急剧缩小,最少仅需要优化万分之八的模型参数即可完成适配;不同增量微调方法可以进行并行或者串行的组合从而达到更优性能,表明了分布在模型参数空间中的智能能力可以进行组合和泛化;增量微调方法具备良好的任务级别的迁移能力,完成特定任务的“能力”可以表示为轻量级参数化的形式,在不同基础模型和不同用户之间共享。

以上研究表明,增量微调是基础模型的重要特性。上述结论将加深对基础模型的认识,为其创新研究与应用提供重要支撑。

相关论文信息:

https://doi.org/10.1038/s42256-023-00626-4

版权声明:本文转载仅仅是出于传播信息的需要,并不意味着代表本网站观点或证实其内容的真实性;如其他媒体、网站或个人从本网站转载使用,须保留本网站注明的“来源”,并自负版权等法律责任;作者如果不希望被转载或者联系转载稿费等事宜,请与我们接洽。

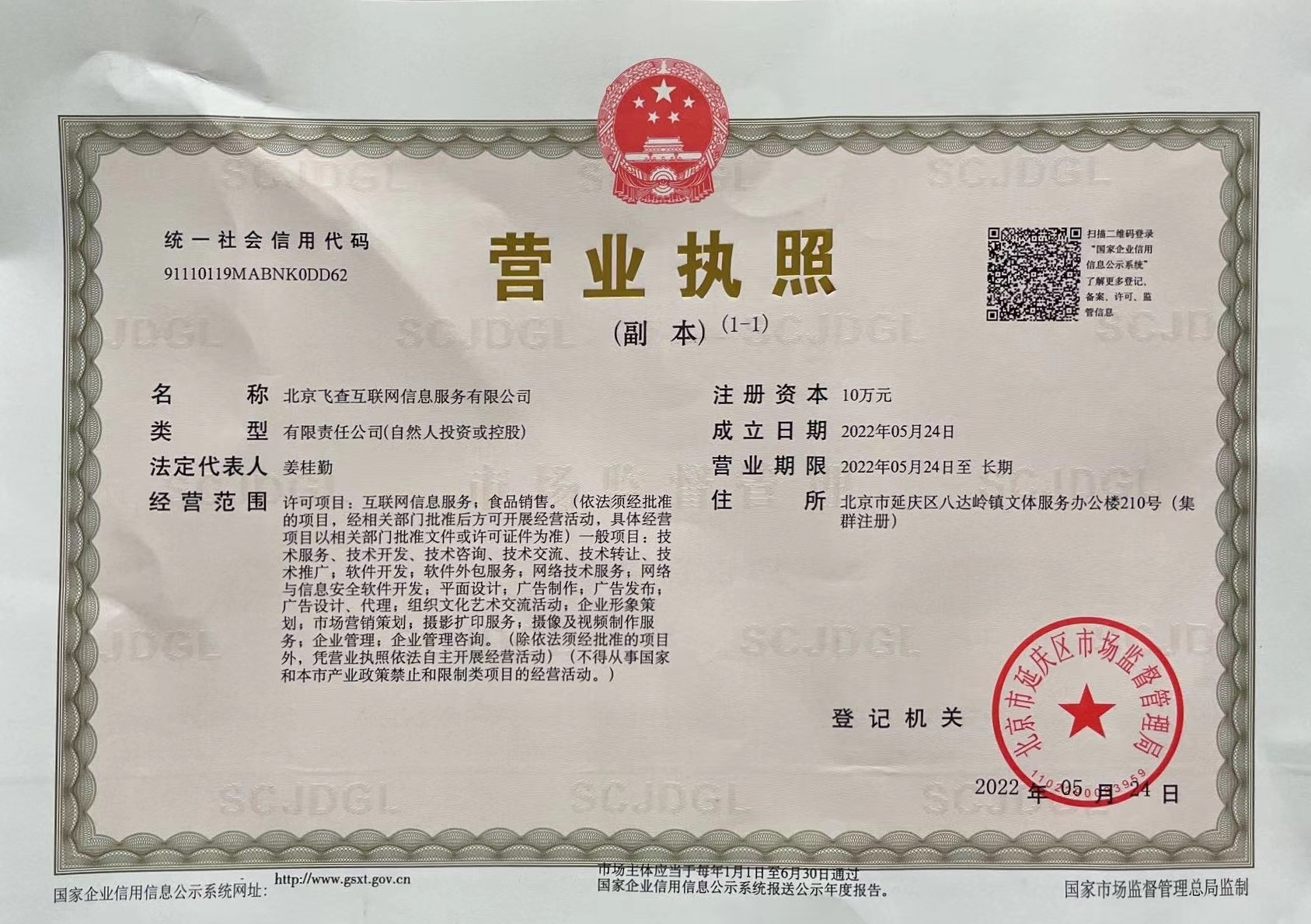

营业执照公示信息

营业执照公示信息